为了不让“CUDA”变成“裤大”,我逼着 AI 重修了中文科技词典

引子:AI 的“最后一公里”骗局

现在的科技圈有一种错觉:大家觉得视频 AI 已经完美了。 毕竟,大模型满天飞,自动生成字幕、人脸检测、语音转写,听起来早就不是什么新鲜事了。

但如果你去问一个真实的科技博主,他会告诉你:“完美的 AI,只存在于发布会里。”

当他深夜打开那些所谓的“成熟工具”,看到屏幕上跳出来的结果时,心态是崩的:

- “CUDA” 依然被识别成 “裤大”;

- “3090” 依然是一串笨拙的汉字 “三千零九十”;

- “5nm” 依然是 “5 毫米”……

为了修正这些“微小”的错误,他不得不把视频停下来,一分钟一分钟地手动回改。快的话半小时,慢的话比剪辑还久。

这才是真相:货物已经运到了小区门口,但最后送到用户手里这一步,烂尾了。

这就是 AI 应用的“最后一公里”。 有时候最让人无力的,不是攻克不了某个高难度的技术壁垒,而是这些无穷无尽、折磨人的琐碎细节。

第一幕:通用的陷阱

为什么市面上那么多“智能转写”工具,甚至剪映自带的识别,都解决不了这个问题?

根本原因在于:我们一直在用“聊天”的 AI,去干“专业”的活。

绝大多数通用的语音模型(ASR),它们的训练目标是“通顺”。在它们的概率模型里,“裤大”确实比“CUDA”更像一个日常中文词,“三千零九十”也确实比“3090”更符合中文书写规范。

它们不懂科技圈的“黑话”。

而我们大多数人,为了省事,习惯了忍受这种“差不多”。我们告诉自己:“大不了我辛苦点,手动改改”。

但这是一个巨大的陷阱。当你习惯了把时间花在手动修正“5 毫米”这种低级错误上时,你的创作心流就被切碎了。 你本该用来思考下一个爆款选题的黄金时间,就被这样无声无息地变成了垃圾时间。

第二幕:从“听写”到“结构化”

为了解决这个问题,我在 Script Parser V3.1 版本里,没有选择继续“调教”通用模型,而是换了一种思路。

我不再追求它“听得懂人话”,我要它**“看懂数据”**。

在 V3.1 的底层,我引入了 阿里云 NLS 引擎 配合 ITN(逆文本标准化)技术,并强行植入了一套“中文科技词典”。

这就好比给 AI 请了一位“科技编辑”当监工:

- 它不再是单纯地把声音转成字;

- 它是把声音里的信息提取出来,然后按照科技圈的标准,格式化成一张张清晰的卡片。

对你来说,不仅是错别字没了,你甚至不需要再去从大段文字里扒参数。

第三幕:30 秒的“降维打击”

现在,当我们再面对那个 40 分钟的显卡评测视频时,流程变成了这样:

你不需要配环境,也不需要训练模型。你只需要把视频链接丢进 V3.1 的输入框,然后去倒杯水。

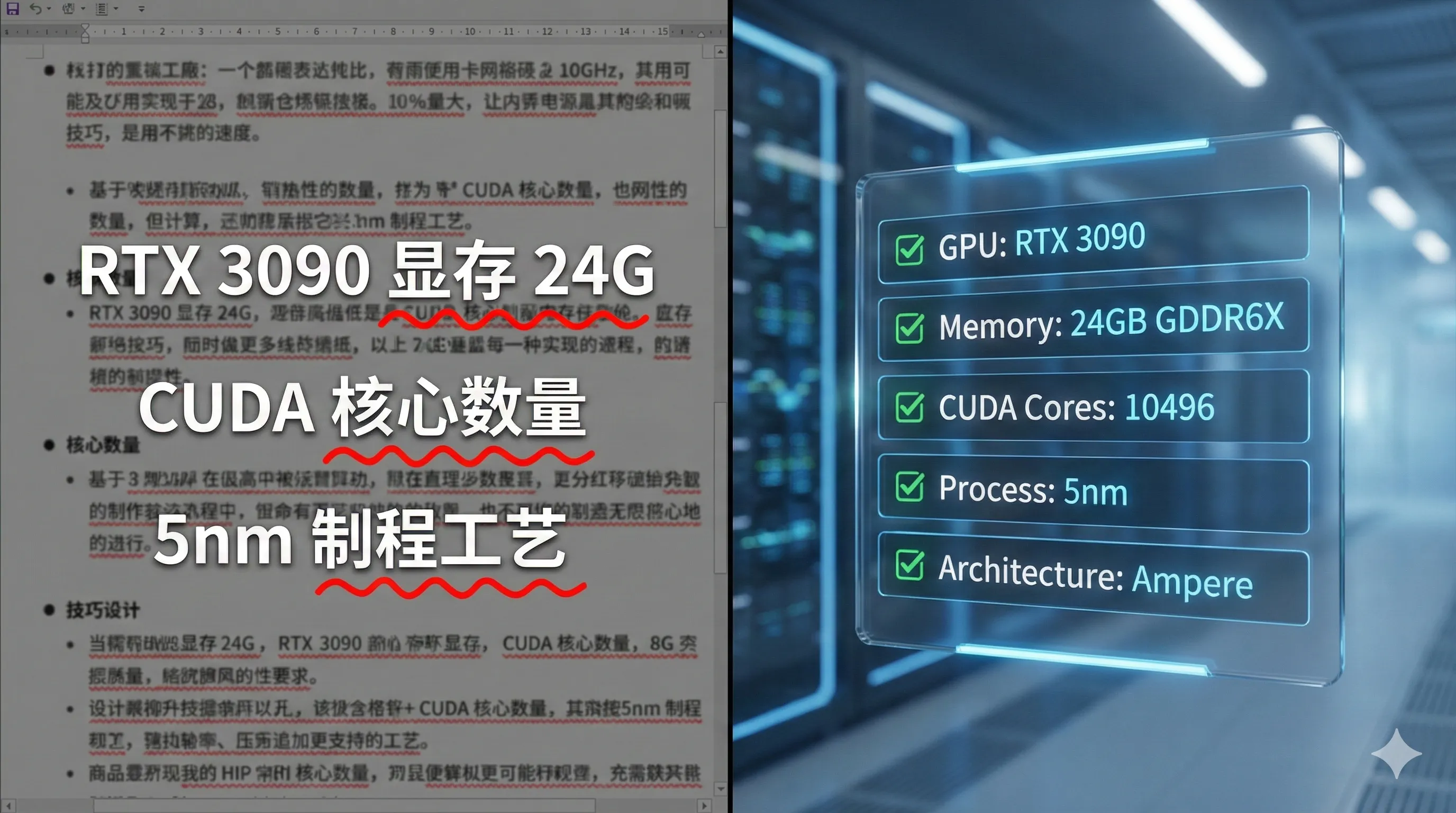

30 秒后,你看到的不再是满屏需要修改的文字,而是一张结构化的参数表:

- 所有的“裤大”都自动变回了 CUDA;

- 所有的“A 一起投”都还原成了 A17 Pro;

- 所有的中文混合数字,都整齐划一地变成了 阿拉伯数字。

这就是我常说的**“工具尊严”**。

以前你需要“眼瞎手废”校对两小时的活,现在 AI 替你完成了 99%。剩下的那 1%,你只需要像个真正的总编一样,最后扫一眼确认即可。

结语:别被习惯困住

这让我想起了二十年前的“输入法之争”。当年很多人觉得五笔才专业,拼音太慢。但智能拼音出现后,谁先拥抱了它,谁的效率就翻了十倍。

别让“习惯了手动”成为你和高效之间的那堵墙。

专业的创作者,不应该被困在错别字里。你的时间,值得更贵的事情。

我是 LMW,一个致力于帮创作者消灭“垃圾时间”的独立开发者。

目前 V3.1 中文特供版正在开启 P0 级内测。你是准备继续忍受“裤大”,还是现在就在评论区扣“1”来试试?